January 7, 2016

長倉 克枝 katsue_nagakura

記者、フリーランスライター。1981年名古屋生まれ、北海道大学獣医学部卒。新聞記者(科学技術部、証券部)などを経てフリー。「日経サイエンス」「wired」「週刊朝日」などに執筆。関心領域はIT全般、テクノロジーと社会をめぐる問題、医療・介護福祉など。

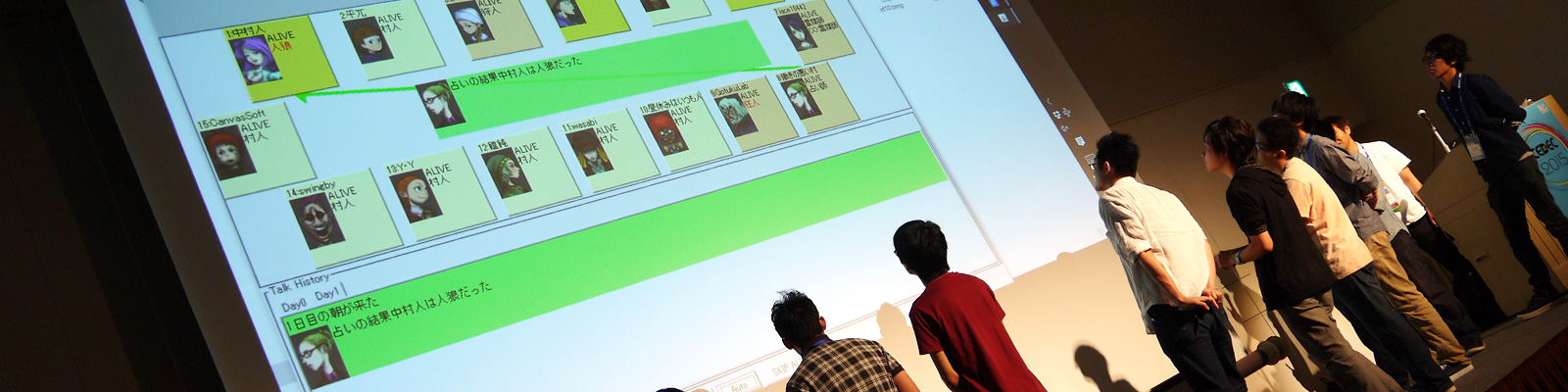

▼2015年8月には、人工知能が人狼ゲームを競う、第1回人狼知能大会が開催された。

人工知能が高度に発達すると、人との会話やコミュニケーションがよりスムーズになっていくだろう。だが、人は決まった会話だけをするわけではない。嘘もつくし、自分でも思ってもみなかったことを言うことさえある。そんな複雑な人間とのコミュニケーションができる人工知能は、どのようにして生み出されるのだろうか。

ところで、「人狼」というゲームをご存知だろうか?複数人が会話や議論から「村人の中に紛れ込んだ『人狼』を見つけ出す」というパーティゲームだ。人を騙したり、嘘を見抜いたりするといった心理的な駆け引きでゲームを進めていく。対面形式で遊ぶためのキットが販売されているほか、オンライン上で遊べるサービスもある。

この人狼をプレイする人工知能の開発を進めているのが「人狼知能」プロジェクトだ。人狼をプレイするプログラムをつくり、コンテストで対戦をして強さを競いながら、人工知能の性能をよくしていく。2015年夏には第1回人狼知能大会が開かれた。人狼知能プロジェクトを率いる東京大学大学院工学系研究科・准教授の鳥海不二夫氏、筑波大学システム情報系・助教の大澤博隆氏に、人狼知能が目指す人工知能の開発について聞いた。

──まず、人狼知能プロジェクトを始めた理由を教えて下さい。

鳥海:3つくらいあります.真面目なのと不真面目なのと(笑)

まず真面目なものから言うと、人工知能研究を進める上で、ゲームをプレイする人工知能を研究すると言うのはもともと重要なテーマとしてありますが、新しい人工知能をつくる上で、人狼をプレイする人工知能をつくることが適しているからです。

これまでにも、ゲームを使った研究として、代表的なものでは将棋やチェス、囲碁をする人工知能の研究が進められてきました。たとえばコンピュータ将棋では、人に勝てる人工知能をつくるというのをひとつの目標としていました。ところが、2013年の電王戦で、コンピュータ将棋がプロ棋士に勝ってしまいました。まだ囲碁では人工知能は勝っていませんが、それも時間の問題でしょう。それなら、ぜんぜん違うゲームにチャレンジするしかないでしょ、となった。

囲碁や将棋は「完全情報ゲーム」といって、情報がすべて公開されています。ゲームの途中からでも盤面を見れば情報はすべてわかりますよね。それに対して、情報が伏せられているとゲームの本質が変わります。このようなゲームは「不完全情報ゲーム」と言います.有名なところだとポーカーや麻雀などですが、人狼もここに含まれます。

人狼には,不完全情報ゲームという囲碁や将棋とは全く異なる性質を持つという意外にも,もうひとつ特徴があります。それは定式化するのが難しいということです。将棋や囲碁では、ゲームの状況といった情報を記号化できるので、コンピュータで扱いやすい。ところが、人狼はコミュニケーションそのものがゲームなので、今どういう状況にあるかを記号化するのがかなり難しいのです。つまり、コンピュータにとって理解するのが難しいコミュニケーションを扱わなければいけない。コミュニケーションを理解し実践する新しい人工知能を作っていく上で,人狼はよい題材になると考えられます。

2つ目はゲームとしてのおもしろさの謎解きです。(人狼知能プロジェクトメンバーで電気通信大学助教の)篠田(孝祐)先生と「ゲームってなんでおもしろいのかな?」という話をしていたんですね。で,ある日篠田先生がゲーム系の集まりでサッカーのボードゲームを買ってきて二人で遊んだのですが、これが衝撃的なくらいつまらなかった(笑)。なんでこんなにつまらないゲームをつくるのか、というくらい(笑)。そこで,「なんでこのゲームはこんなにつまらないんだろうか?」と二人で考え始めたんです.私はゲームをそれほどやらないんですが、人狼は面白いし、それ以外にも世の中は面白いゲームであふれています。ゲームのおもしろさを決めるものはなんなんだろう、その謎を解きたいよね、というのが目的のひとつです。

3つ目は不真面目パターン(笑)。私はもともと名古屋大学にいたんですが、当時研究室に学生だった(広島市立大学助教の)稲葉(通将)先生がいたんですね。彼はアナログゲームが好きで、人狼を研究室に持ってきてやっていたら、はまってしまった。そこで、「これを研究テーマにしたら好きなときにいつでも人狼ができる」と思ったんですが、実際に始めて見ると案外できないんですけれどね(笑)。それが2011年くらいかな。

研究としては,ネット上のBBS(掲示板)で人狼をやっている人たちがいるんですが、まず、そのデータをダウンロードしてそれを使って何かやろうとしました。次の年に広島市立大学にうつった稲葉先生にデータを渡して分析をして、ゲームプログラミングワークショップで論文を発表しました。

大澤:私はその発表を後で聞いて,人狼知能を知りました。

──人狼知能によって、人工知能はどのよう変わっていくのでしょうか?

鳥海:今までの人工知能は、情報のインプットとアウトプットが正しいという前提で動いていますよね。コンピュータに嘘の情報が入ってきたら、間違った結果になる。ミスはあるとしても、きちんと計算した結果が出て信じるに値するというのが、これまでの人工知能です。

ところが、これからの人工知能はそうではなくなります。「これからの人工知能はドラえもんだ」という話を私はよくするんですが、ドラえもんは嘘をつきますよね。逆に、嘘の情報がインプットされることもあります。のび太くんがドラえもんを騙して、ひどい目にあう、というのは黄金パターンですよね。

大澤:ロボット工学三原則というのがあって、そこではロボットは人を傷つけてはいけないとされています。でも、ロボットが嘘をつくことは禁止されていないんです。人を傷つけないために、ロボットが嘘をつくのはありうることです。

鳥海:そうそう。ドラえもんは居候なのに「今日の飯まずい」とか言ったら、いろいろと問題が起きますよね(笑)。「個性的な味だね」とかいろんな嘘を言うわけです。それって嘘なんだけど、そうしないと円滑なコミュニケーションは取れない。そうやって、人工知能が嘘をつくという将来が必ずくる。そうなると、人間は「人工知能は嘘をつく」という認識を持つ。それなら、今度は人工知能が人間を説得する能力が必要になってくるわけです。

さらにインプットの情報に嘘が入ってくる可能性も十分あります。つまり、人工知能が騙されることもあると、今後は考えないといけない。そうすると、嘘を見抜く処理系が必要になります。論理矛盾はもちろんのこと、論理矛盾がなくても「何かがおかしい」というのを人間は感じることができます。そういうことを文脈から感じ取る能力も、これからの人工知能には必要になってきます。つまり、現象として何かが起きた時に、そこにあるおかしな点を発見する、違和感を覚えることができる人工知能ですね。

例えば、私は金融情報学の研究をしていたのですが、その中でインサイダー取引を発見するプログラムの研究をしていました。株価変動や売買記録のデータから違和感を抽出して、このときにインサイダー取引があったのではないかと推測するわけです。明確におかしい、というのが出てくるわけではなく、全体の中の違和感を発見するのです。それと同じことを、人工知能がコミュニケーションの中でやっていくというものです。

今からそういう研究をしていかないといけない。と考えた時に、人狼知能を作るときに必要となる、「嘘をつく」「嘘を見抜く」「相手を説得する」といった技術を培っていくことは重要なミッションということになります。

大澤:嘘をつく時人はこうする、という心理学的知見ですでにわかっていることは見抜けると思うんですが、そうじゃなくて場面や文脈によって変わることも人工知能が解いていけると魅力的です。

鳥海:まだこれから研究が進んでいくところなので確かなことは言えませんが、大量のビッグデータの中から違和感を見つけるような人工知能になるのではないかと予想しています。人は、文脈や表情など複数の情報から、「この人はこんなことをするはずがない」という言い方をよくしますが、人工知能がそのようなことをできるようになるのかなと。

大澤:「この人はこんなことをするはずがない」というのは、その人の個性を見ているんですね。人狼は、人の個性を読むゲームだと思っています。

鳥海:その人のモデルを読む、心理的なものを読む、そういったいくつかを複合的にやっていくことで、嘘が蔓延する社会の人工知能ができていきます。

──人工知能がコミュニケーションをするために必要な要素が、人狼の中に入っているということでしょうか?

鳥海:そうですね。人狼は人間社会の縮図なので、そういったコミュニケーションが人狼の中には詰まっています。

(後編に続く)