September 26, 2025

清水 亮 ryo_shimizu

新潟県長岡市生まれ。1990年代よりプログラマーとしてゲーム業界、モバイル業界などで数社の立ち上げに関わる。現在も現役のプログラマーとして日夜AI開発に情熱を捧げている。

小規模でも高性能なLLMがたくさん出てくるようになり、LLMのファインチューニング手法もこなれてきた。かつては、QLoRAなどのファインチューニングでは語尾やフォーマットしか学習できないと言われたり、下手にファインチューニングするとそれまでの知識を忘れてしまう問題などがあった。

現在は、継続的事前学習(CPT;Continual Pre-Training)を用いて性能の劣化を防ぎながら新しい知識を学習することができるようになってきた。

また、LLMの扱えるコンテキスト長も、一年ほど前は4000〜8000と言うかなり小規模なものだったが、今は12万から26万、ものによっては100万トークンを超えるほどの長大なコンテキストを扱うことができるようになった。

長大なコンテキスト長は、文脈内学習(ICL;In-Context Learning)を可能にし、膨大な電力と時間を必要とするCPTやファインチューニングに比べて、プロンプトにただもとになる情報を加えるだけで良いICLは手軽だ。

例えば筆者の場合、取材で録音した素材をそのままWhisperで文字化し、誤字脱字などが入ったままのWhisperの文字起こしデータをそのままGeminiに全文投入して「2万字程度の原稿にしろ」と指示して原稿の下書きを書くことが日常的になってきた。

クラウド上にあるプロプライエタリなLLMが使える状況ならこれで十分なのだが、もう少し複雑なタスク、例えば絶対にクラウドにアップロードすることのできない秘密情報などを含む非構造化データから事実関係を読み取り、解釈を加えて再整理し、構造化するなどの仕事は、長らく難しいとされてきた。

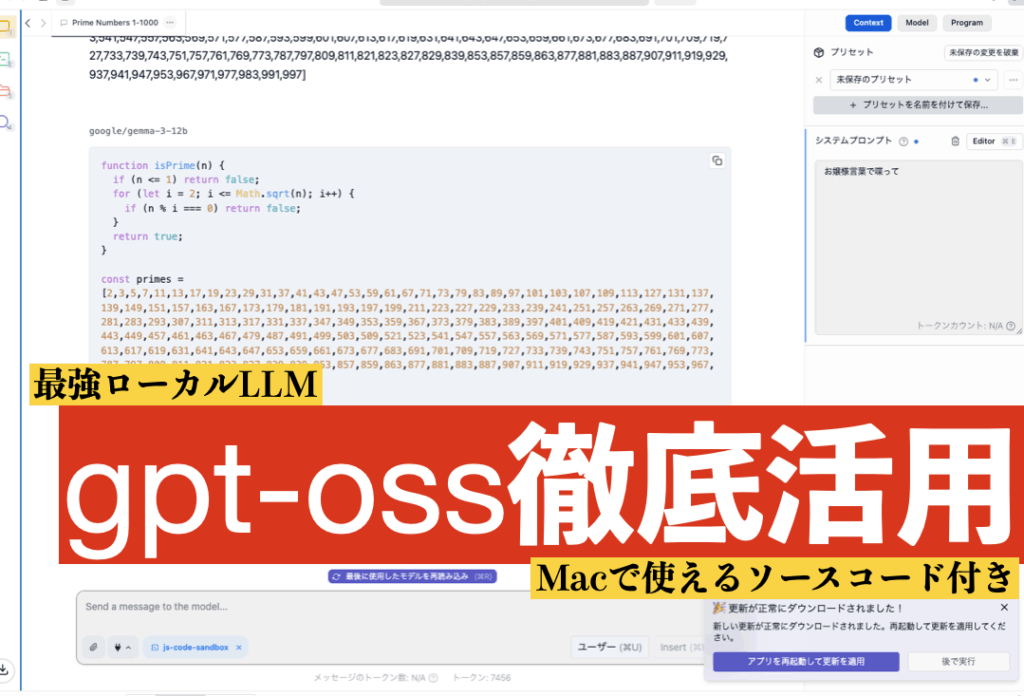

ところがこの状況を一変させたのがgpt-ossだ。

OpenAIによれば、gpt-oss-120bの推論能力はo4-mini相当、gpt-oss-20bの推論能力はo3-mini相当だという。個人的にはo3-miniが登場したときに、あまりのプログラミング能力の高さに衝撃を受け、それがバイブコーディングと呼ばれる前から積極的に使ったハッカソンなどを開催するほどのめり込んだものが、目の前のわずか数十万円のコンピュータで動くことが信じられなかった。

手始めに、自宅と会社にあるKenoteやPowerPoing、PDFやExcelのデータをひたすらgpt-ossに読ませて構造化し、いつでも検索したり、そこに貯められた知見を取り出せるようにしてみた。

これが思いのほか便利で、特に筆者自身は度々、授業や講演のためのスライドを作る際、「昔こんなスライド書いたよな」と思いつつ、どこにあるかすぐに思い出せなくて結局同じような図を作図し直すという馬鹿馬鹿しいことに時間を取られることがあった。

探す場合もあるが、クラウド上にあるスライドデータは、そもそも重たく、しかも筆者のスライドの場合、大量の画像や動画が含まれるので、いちいちダウンロードしてきて中身を調べても、目当てのスライドに辿り着くまでに一時間を要したりする。

このシステムを作ってから、そういうことが一切なくなった。必要なスライドが瞬時に呼び出せる。

このシステムは、単体のMacBookPro上で動作し、LLMはMacBookProで動く。ただしメモリーはそこそこ必要になる。今あるハードウェアでやるには、100万円程度の出費がどうしても必要になる。

その辺りも、そろそろ発売されるNVIDIAのDGX Sparkおよびその互換機が出れば解決される。これは60万円程度と言う驚異的な低価格で128GBのユニファイドメモリを提供するものだ。gpt-oss-120bももちろん動作する。というかgpt-oss-120bはDGX Sparkに向けてチューニングされていると言ってもいい。

こうなると、ただICLするだけでなく、ちょっとした専門知識を持たせたLLMを自前でCPTなりファインチューニングなりしたくなる。

そのために、筆者は本欄の過去12年間に渡る原稿を軒並みCPTで学習させてみたところ、きちんと知識を持ったまま新しい知識を獲得できることを確認した(Free-AI社のブログ)。

しかし、これはあくまでもベースモデルのCPTができただけのことであって、本当に欲しいのは、「質問」「応答」または「指示」「応答」のペアのデータセットで学習することだ。

そうしないと、質問に対して答えてくれないヘンテコなAIが出来上がってしまう。

これまでの常識では、それほどまでに高度なデータセットは、クラウド上のプロプライエタリなスケールのLLMにしか作れなかったのだが、gpt-oss-120bの推論能力はずば抜けており、記事をもとに質問と回答のペアを作ったり、そのペアの品質を評価したりと言うことが自動的にできる。

例えば、「なぜ、すべての大学、すべての学部でAI教育を行うべきなのか」と言う2019年の記事から、以下のような質問と回答のペアを自動的に抽出することができる。

{

"result": [

{

"question": "日本政府はAI教育に関してどのような目標を掲げているか?",

"answer": "政府は令和元年に『データサイエンス・AIを理解し、各専門分野で応用できる人材を養成』する方針を示し、年間25万人が基礎的なAI活用能力を身につけることを目指しています。これはAI技術者そのものを大量に育成するのではなく、 既存の専門分野を持つ人々がAIを活用できるようにすることが主目的です。"

},

{

"question": "具体的な取り組みとして大学や高専で行われるべき施策は何か?",

"answer": "文部科学省は、数理・データサイエンス・AIの応用基礎力を習得できる標準カリキュラムの開発・全国展開、インターンシップの表彰、認定コースの導入、入試でのAI志向入学者選抜支援、留学生受け入れ促進など、教育環境整備を段階 的に実施する計画を示しています。"

},

{

"question": "AI教育を全学部で実施する意義は何か?",

"answer": "AIは特定の専門家だけでなく、あらゆる職種や日常生活に浸透すべき技術と位置付けられています。全学部でAI教育を行うことで、将来の社会実装に必要な幅広い人材を確保し、AIが日常的に活用される基盤を作ることが目的です。"

},

{

"question": "過去のコンピュータ普及とAI普及の類似点は何か?",

"answer": "記事では、かつてコンピュータが専門家だけのツールであった時代と同様に、AIも現在は限られた専門家しか扱えない段階にあると指摘しています。コンピュータが一般化しスマートフォンへと進化したように、AIも同様に広く浸透し、 誰でも使える技術になることが期待されています。"

},

{

"question": "AIがコンピュータと異なる点は何か?",

"answer": "コンピュータは電源を入れ、操作しなければ機能しませんが、AIは設置するだけで自律的に学習・応用し続けられる点が異なります。そのため、AIは人間の生活空間(キッチン、トイレ、リビング等)に自然に組み込まれ、従来のコンピュータ以上に生活を支える可能性があります。"

},

{

"question": "AI教育に対する現在の日本の政策的姿勢は?",

"answer": "文部科学省は全ての国立大学の全学部でAI教育を実施すると表明し、急速に政策を進めています。これはAI社会実装を国家レベルで推進し、AI活用が可能な人材を早急に育成するための戦略的な動きと位置付けられています。"

},

{

"question": "将来的にAIはどのように人々の生活に浸透すると予測されているか?",

"answer": "記事は、AIがコンピュータからスマートフォンへと進化したように、日常生活のあらゆる場面に溶け込むと予測しています。AIは単なるツールではなく、生活の隙間で自律的に機能し、将来的には幼稚園児がAIの使い方を教えるほど普及 する可能性が示唆されています。"

}

]

} これはちょっと気の利いた大学生のインターンができる以上の品質の質疑応答集であり、こんなものが小一時間ほどで大量に生成できる。455本の記事があるから、だいたい4000問以上の質疑が獲得可能で、これは非常に有力なデータセットとなる。

このデータセットをもとに「指示」「質問」「応答」データセットを作ってCPTすれば、任意のLLMを作り出すことができる。

例えば小規模の、それこそ8B程度のサイズの「専門的知識を獲得したオリジナルのLLM」とgpt-oss-120bを組み合わせれば、より効果的なAIシステムを構築することができるはずだ。

ただし、gpt-oss-120bはきちんと能力を引き出すのにコツがいることが使い始めてわかった。

いわゆるリーズニングモデルと同様の高度な推論機能を持っているため、そのまま使うとやや扱いにくいのだ。

実際、ローカルに限らずLLMは、それぞれバージョンによって細かな挙動が変わったり、有効なプロンプトに癖があったりする。

特にクラウドで提供されるプロプラのLLMは、同じ名前がついていても昨日のLLMと今日のLLMが全く同じものとは限らないところが厄介だ。そう言う意味では、ローカルで動くLLMの方が挙動が安定していて癖を掴みやすく、新しいLLMの癖を掴むのに時間をかけるくらいなら、手に馴染んだ道具として手元のローカルLLMに習熟した方がいいと言うことが次第に広まっていくだろう。

なお、筆者の担当する「教養としてのAI講座」で9/28日曜日の午前11時から実際にgpt-ossを使ったプログラミングをどのように行うか、ソースコード付きで解説する特番を行う。

https://shirasu.io/t/zelpm/c/shi3zlab/p/20250926141301

gpt-ossは極めて強力なので、まだまだ使い方を深掘りしていくことができるだろう。

どちらにせよ本当に面白い時代を生きているものだ。